Η περιγραφή μιας εικόνας είναι ιδιαίτερα εύκολη για τους ανθρώπους- αλλά αυτό δεν ισχύει για τους υπολογιστές. Ωστόσο, αυτό φαίνεται πως αρχίζει να αλλάζει, και ένδειξη είναι η δουλειά ερευνητών της Google, που ανέπτυξαν ένα σύστημα machine learning το οποίο είναι σε θέση να παράγει αυτόματα λεζάντες για να περιγράψει εικόνες την πρώτη φορά που τις «βλέπει».

Όπως γράφουν οι Όριολ Βινιάλς, Αλεξάντερ Τόσεφ, Σάμι Μπέντζιο και Ντουμίτρου Ερχάν, επιστήμονες της εταιρείας στο research blog της Google, αυτού του είδους το σύστημα θα μπορούσε να βοηθήσει μακροπρόθεσμα ανθρώπους με προβλήματα όρασης να κατανοήσουν εικόνες, να παρέχει εναλλακτικό κείμενο για εικόνες σε σημεία του κόσμου όπου οι συνδέσεις δικτύου δεν είναι καλές και να καταστήσει ευκολότερη την αναζήτηση εικόνων στο Google.

Πρόσφατες έρευνες είχαν ως αποτέλεσμα τη σημαντική βελτίωση του εντοπισμού, της καταχώρησης και της επισήμανσης/ τιτλοφόρησης αντικειμένων. Ωστόσο η ακριβής περιγραφή μίας σύνθετης σκηνής απαιτεί βαθύτερη αναπαράσταση του τι συμβαίνει, «πιάνοντας» το πώς τα διάφορα αντικείμενα σχετίζονται το ένα με το άλλο και στη συνέχεια «μεταφράζοντας» το σύνολο των «συμπερασμάτων» σε φυσική γλώσσα.

«Πολλές προσπάθειες να κατασκευάσουμε computer-generated φυσικές περιγραφές εικόνων προτείνουν τον συνδυασμό σύγχρονων state of the art τεχνικών τόσο στο computer vision όσο και στο natural language processing, για τον σχηματισμό μιας συνολικής προσέγγισης περιγραφής εικόνας. Αλλά τι θα γινόταν αν αντί για αυτό συνδυάζαμε πρόσφατα μοντέλα computer vision και γλώσσας μέσα σε ένα μοναδικό, από κοινού ‘εκπαιδευμένο’ σύστημα, λαμβάνοντας μια εικόνα και άμεσα παράγοντας μία ακολουθία λέξεων – αναγνώσιμη από ανθρώπους- για να την περιγράψουμε;» ρωτούν οι ερευνητές.

Η ιδέα προκύπτει από πρόσφατες προόδους στον τομέα του machine translation μεταξύ γλωσσών, όπου ένα RNN (Recurrent Neural Network) μεταφράζει, για παράδειγμα, μια γαλλική πρόταση σε μια απεικόνιση (vector representation) και ένα δεύτερο RNN τη χρησιμοποιεί αυτήν για να παράξει μία πρόταση στα γερμανικά.

Όπως αναφέρουν οι ερευνητές, η ιδέα είναι η αντικατάσταση του πρώτου RNN και των αρχικών λέξεων που εισάγονται με ένα βαθύ CNN (Convolutional Neural Network) που είναι ειδικά «εκπαιδευμένο» για να ταξινομεί αντικείμενα σε εικόνες. Η δυνατότητα που «ανοίγεται», όπως επισημαίνουν, είναι αυτή της «εκπαίδευσης» του συστήματος στο σύνολό του πάνω σε εικόνες και λεζάντες, έτσι ώστε να μεγιστοποιείται το ενδεχόμενο ταιριάσματος μιας περιγραφής με μια εικόνα.

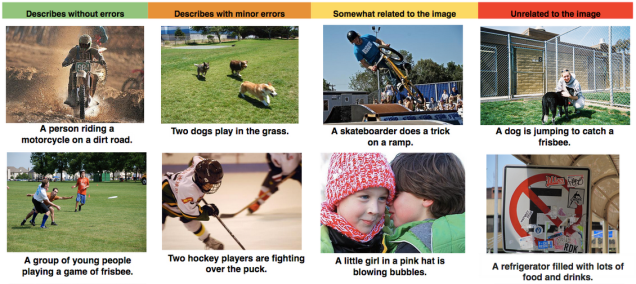

Το σύστημα δοκιμάστηκε σε δημόσια διαθέσιμα datasets, περιλαμβανομένων των Pascal, Flickr8j, Flickr30k και SBU, και επιδεικνύουν καλά αποτελέσματα.

«Μία εικόνα μπορεί να αξίζει όσο 1.000 λέξεις, αλλά κάποιες φορές είναι οι λέξεις που είναι πιο χρήσιμες- οπότε είναι σημαντικό να βρούμε τρόπους να μεταφράζουμε από εικόνες σε λέξεις αυτόματα και με ακρίβεια» σημειώνουν οι ερευνητές.